Big Data oder generell Datenanalyse sind ein wesentlicher Bestandteil der Industrie-4.0-Vision. Die Vorteile von Big Data eröffnen ganz neue Möglichkeiten in der industriellen Produktion, aus Erfahrungen zu lernen und Entscheidungsprozesse zu optimieren und so zum Beispiel kritische Situationen zu vermeiden. Bevor Big Data in breiter Front im industriellen Umfeld zum Einsatz kommen kann und so ein Bestandteil von Industrie 4.0 wird, gilt es noch, einige Voraussetzungen zu schaffen.

Autoren Jan Schlake Benjamin Klöpper Marcel Dix Martin Hollender Mitarbeiter des ABB Forschungs- zentrums in Ladenburg

Die Anwendung von Big-Data-Technologien speziell im Industrieumfeld ist jedoch nicht trivial. Aus diesem Grund rief das BMBF das FEE-Projekt ins Leben, an dem neben anderen Industrieunternehmen und einigen Universitäten auch das ABB Forschungszentrum und der ABB Geschäftsbereich Chemie beteiligt sind. In diesem Projekt werden neuartige Big-Data-Ansätze entwickelt, die dem Bedienpersonal von verfahrenstechnischen Anlagen helfen, Situationen zu vermeiden, in denen es durch Alarmfluten überfordert ist und gegebenenfalls falsche Entscheidungen trifft.

Potenziale und Herausforderungen

Big Data und generell Datenanalyse sind ein wesentlicher Bestandteil der Industrie 4.0-Vision. In einer typischen Prozessanlage findet sich jedoch in der Regel eine Vielzahl von Datensilos: gesammelte Daten werden in isolierten Informationssystemen gespeichert und verarbeitet. Durch die isolierte Speicherung und Verarbeitung der Daten wird das automatisierte Lernen aus historischen Daten erschwert. In einem solchen Zustand ist Datenanalyse eine sehr mühselige Aufgabe und erfordert sowohl tiefgehendes Verständnis für die einzelne Anlage wie auch erhebliche Personen- und Zeitaufwände.

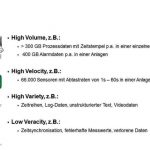

Big-Data-Technologien versprechen die Möglichkeit, Lösungen für Industrial Analytics leichter bereitzustellen und flächendeckend auszurollen. Sie werden entwickelt, um Daten in großen Mengen (V1 – high volume), mit hoher Geschwindigkeit (V2 – high velocity) oder in sehr unterschiedlichen Formaten (V3 – high variety) zu behandeln. Durch das Vorhandensein von gleichartigen Daten in unterschiedlichen Datensilos kommt es zusätzlich noch zum Problem der nicht vorhandenen Glaubhaftigkeit bzw. zu widersprüchlichen Aussagen der Daten (V4 – veracity). Ein echtes Big-Data-Problem liegt vor, wenn es durch alle vier Vs charakterisiert werden kann.

Die heutigen Systeme und Problemstellungen in der Produktion erfüllen immer häufiger die charakteristischen Bedingungen eines Big-Data-Problems, z. B.:

- Prozesshistorians speichern Daten in hoher Auflösung über Jahre

- Alarmmanagementsysteme sammeln große Mengen an Eventdaten

- Labormessungen werden regelmäßig durchgeführt und ergänzen die Online-Messung von Produktdaten

- Standard-Operating-Prozeduren liefern Informationen über den Betrieb der Anlage

- Maintenance- und Asset-Management- Systeme informieren über den aktuellen Gesundheitszustand von Anlagenkomponenten

Die Verwendung von Big-Data-Analysen auf allen diesen Datenquellen versprechen die Vermeidung von kritischen Situationen in der Prozessindustrie. Dabei stoßen existierende Systeme immer mehr an ihre Grenzen: Aufgrund wachsenden Datenaufkommens in Bezug auf Volumen und Geschwindigkeit sind klassische relationale Datenbanken oder Prozesshistorians oft überfordert.

Parallel dazu führt der immer weiter erhöhte Automatisierungsgrad zu einem Verlust an erfahrenen Anlagenfahrern. Diese sind dann in komplexen Situationen zu überlastet, um das dynamische Verhalten ihrer Anlage zu beherrschen. Besonders in unerwarteten Situationen, wenn es zu vielen Alarmen kommt, macht sich der fehlende Erfahrungsschatz bemerkbar.

Denkt man diese Punkte konsequent weiter, ergeben sich somit zahlreiche Anwendungsmöglichkeiten von Big Data für den Betrieb einer Anlage, z. B.:

- Monitoring

- Alarmmanagement

- Ursachenanalyse

- Plant Asset Management

- Entscheidungsunterstützung

Parallel zu den Möglichkeiten wird sich auch die Arbeitsweise ändern. Experten aus den verschiedenen Abteilungen können zusammenarbeiten und so ihr Wissen effizient bündeln, um gemeinsam den Betrieb der Anlage zu verbessern.

Alarmfluten beherrschen

Alarmmanagement ist dabei einer der Bereiche, in denen Big-Data-Technologien zum Einsatz kommen werden. Zentraler Gedanke ist, solche Alarme zu vermeiden, die in der jeweiligen Situation keine hilfreiche Information für die Anlagenfahrer darstellen. Überflüssige Alarme können von wichtigen Sachverhalten ablenken und zu Fehlentscheidungen führen. Kritische Prozesssituationen werden so durch eine begrenzte Anzahl von Alarmen vermieden, das menschliche Auffassungsvermögen wird nicht überlastet.

Die Einführung von Leitsystemen in der Prozessindustrie hat unzweifelhaft die Anzahl von Alarmen pro Bediener im Laufe der Zeit exponentiell erhöht. Moderne Prozessanlagen weisen einen hohen Grad an Verbindungsflexibilität auf, sodass eine Störung im Betrieb einer Teilanlage durch die vorhandenen Material-, Energie- und Informationsverbindungen Auswirkungen auf die gesamte Anlage hat. Die zu diesen Prozessvariablen assoziierten Alarme werden ausgelöst. Alarmmeldungen überlasten das Bedienpersonal und es wird nicht in der Lage sein, sämtliche Alarme angemessen zu untersuchen. Eine sogenannte Alarmflut ist die Folge. In dieser Situation kann es sein, dass der Bediener einen sicheren Betrieb der Anlage nicht mehr garantieren kann. Im ungünstigsten Fall werden Umwelt und menschliche Leben gefährdet.

Die Big-Data-Methode beinhaltet in diesem Fall die vier Basisschritte:

- Identifizierung von Alarmfluten

- Erstellen von Alarmgruppen

- Alarmmanagement-Rationalisierungs- treffen, in denen automatisiert erstellte Vorschläge begutachtet und schließlich freigegeben werden

- Implementierung im Alarmsystem

Schlussendlich können Ansätze wie der vorher skizzierte als Basis genutzt werden, um ein Entscheidungsunterstützungssystem zu entwerfen, das den Anlagenfahrer der Zukunft in kritischen Situationen unterstützt. Um die benötigten Informationen rechtzeitig zu bekommen, müssen Big-Data-Technologien eingesetzt werden, sodass der Fluss großer Datenmengen online verarbeitet werden kann.

prozesstechnik-online.de/cav0415460

Unsere Whitepaper-Empfehlung

Wasserstoff gilt als Schlüssel für die Dekarbonisierung der Chemieindustrie. Doch die Nutzung des vermeintlichen Hoffnungsträgers Hydrogen birgt auch Gefahren und stellt die Branche vor neue Herausforderungen, die das gratis Whitepaper „H2 wie Hoffnungsträger?“ näher für Sie…

Teilen: