Selbst die genauesten Messgeräte weisen Messfehler auf, die sich in der Regel mit der Zeit erhöhen. Solche Fehler müssen regelmäßig quantifiziert werden, um festzustellen, ob die Messungen zuverlässig genug sind, um ihren Verwendungszweck zu erfüllen. Dies erfüllt die Kalibrierung. Sie ist der Vergleichsprozess der Ausgangswerte eines Messgerätes mit einer bekannten Referenz für eine bestimmte Messgröße. Eine Kalibrierung soll die Messfehler eines Gerätes ermitteln, oft UUT (Unit Under Test) genannt. Ein UUT kann wiederum als Referenz zur Kalibrierung eines anderen Gerätes verwendet werden. Letztlich führt diese Kette von Kalibrierungen zurück zu nationalen oder internationalen Primärreferenzen, die so eine Garantie für eine messtechnische Rückverfolgbarkeit schaffen.

Hohe Ableitfähigkeit, sehr gute Fließfähigkeit, niedrige Viskosität – und jetzt mit FDA-Zulassung: RAMPF Advanced Polymers hat sein leistungsstarkes...

Die gemeinsame Referenz für Messungen erlaubt Industrieunternehmen, eine Vergleichbarkeit und einen Transfer von Produktrezepturen zu jedem beliebigen Ort der Welt herzustellen. Kalibrierungen ermöglichen es auch, Messgeräte zu verwalten und Messdrifts zu erkennen, die sich negativ auf die Einhaltung von Produktrezepturen und damit verbundene Produktionsprozesse auswirken. Dennoch kalibrieren viele Unternehmen nur, wenn sie wegen lokaler Anforderungen oder Qualitätsvorgaben dazu gezwungen sind. Selbst in einfachen Prozessen kann über einen längeren Zeitraum hinweg ein kleiner Messfehler zu einer erheblichen Verschwendung von Ressourcen wie Energie und Rohstoffen führen, deren Kosten die einer Kalibrierung bei weitem übertreffen. Sind Sicherheits- und Umweltbelange davon betroffen, sollte die Notwendigkeit von regelmäßigen Kalibrierungen generell außer Frage stehen.

Kalibrierintervalle als Quelle für Mehrwert

Kalibrierungen werden oft eher als kostspieliger Aufwand denn als potenzielle Quelle für Mehrwert wahrgenommen. Oft erfolgen Kalibrierungen starr nach festgelegten Regeln, anstatt Regeln anzupassen, um das Produktionsrisiko zu minimieren und mehr Prozesskontrolle zu erhalten. Fixe Kalibrierintervalle sind eine typische Folge dieser starren und veralteten Regeln. Kalibrierintervalle sollten so gewählt werden, dass bei einem tolerierbaren Risiko ein Messfehler nicht außerhalb eines akzeptablen Bereichs abgedriftet ist.

In der Praxis wird das meist anders gehandhabt: Oft sind Kalibrierintervalle pauschal auf ein Jahr definiert – der Bequemlichkeit halber, da sie sich gut in jährliche Planungszyklen einarbeiten lassen.

Diese Praxis ist so tief verwurzelt, dass oft behauptet wird, dieser Zeitraum sei als Anforderung in der ISO 9001 angegeben. Der Standard besagt jedoch lediglich folgendes: „Soweit zur Sicherstellung gültiger Ergebnisse erforderlich, müssen die Messmittel in festgelegten Abständen oder vor dem Gebrauch kalibriert und/oder verifiziert werden.“ Das heißt, die Intervalle müssen im Voraus bestimmt und festgelegt werden. Aber es bedeutet nicht, dass die Intervalle für sämtliche Messinstrumente alle gleich sein sollten. Die einzige andere relevante Anforderung von ISO 9001 für Kalibrierintervalle ist, „deren fortlaufende Eignung von Ressourcen zur Überwachung und Messung sicherzustellen“.

Das beste Intervall ist jenes, welches den Zeitraum, währenddessen ein Messgerät „out of tolerance“ (OOT) ist, reduziert und gleichzeitig die Betriebskosten minimiert. Leider stehen diese beiden Ziele typischerweise im Widerspruch zueinander. Das eine Extrem wäre, auf Kalibrierungen ganz zu verzichten, um das Kostenziel zu erfüllen, wobei das Risiko im Laufe der Zeit steigt. Das Gegenteil wäre der Fall, wenn täglich kalibriert werden würde. Das optimale Kalibrierintervall ist demnach ein Kompromiss aus Kosten und Risiko.

Balance zwischen Risiko und Kosten finden

Es gibt mehrere Methoden, um geeignete Kalibrierintervalle zu bestimmen; die meisten von ihnen beruhen auf dem risikobasierten Ansatz: Dabei wird das akzeptable Risiko definiert und daraus werden die resultierenden Kosten abgeleitet – und nicht umgekehrt. Die optimale Balance zwischen Risiko und Kosten lässt sich nun mit zwei verbesserten Methoden finden. Jede der beiden Methoden hat Vor- und Nachteile und erfordert unterschiedliche Voraussetzungen.

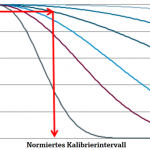

Bei der ersten Methode, der sogenannten Zuverlässigkeitsmethode, wurde eine statistische Methode weiterentwickelt. Sie benötigt relativ wenige Daten und erlaubt eine Vorhersage aus dem letzten Kalibrierergebnis. Dafür werden je nach Gerätetyp, Messtechnologie und Erfahrungswerten verschiedene Zuverlässigkeitsmodelle ausgewählt. Die Methode legt fest, wie die „normierte Zuverlässigkeit“ durch Zuverlässigkeitskurven segmentiert wird. Die entsprechende Zuverlässigkeitskurve wird dann anhand der Messfehler der letzten ausgewählten Kalibrierung ausgewählt. Anschließend wird ein Zuverlässigkeitsziel Rt angewendet (bestimmt durch die Gerätekritikalität), um den Wert zu finden, an dem sich der Schnittpunkt mit der Zuverlässigkeitskurve ergibt. Daraus folgt das normierte Intervall, aus dem das neue Kalibrierintervall berechnet wird.

Die Methode lässt sich relativ einfach anwenden und erfordert wenig Eingangsdaten wie Kritikalität und Kalibrierwerte, die zudem leicht verfügbar sind. Im Gegensatz dazu verwenden alle bisher bekannten Methoden nur Bestanden-/Nicht-bestanden-Ergebnisse und nicht die Kalibrierwerte selbst. Auch dann, wenn Daten nur begrenzt verfügbar sind, ist das Verfahren robust genug, um Kalibrierintervalle zu liefern. Zudem kann die Methode für jeden Gerätetyp angewendet werden, wenn das entsprechende Modell (spezifische Zuverlässigkeitskurven) angewendet wird.

Monte-Carlo-Simulation passt sich an Gerätezustand an

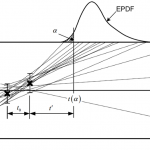

Die zweite Methode basiert auf der sogenannten Monte-Carlo-Simulation. Die Methode nutzt die bereits vorliegenden letzten beiden Kalibrierergebnisse und die dort festgestellte Messunsicherheit für eine Messstelle und simuliert mögliche Drifts. Als Ergebnis der Simulation wird eine Wahrscheinlichkeitsdichtefunktion (empirical probability density function, EPDF) erzeugt, die zeigt, wann die Messwertverschiebung den erlaubten Fehler (maxium permissible error, MPE) überschreitet. Je kritischer die Messstelle ist, desto niedriger sollte der Wert für das überschrittene Signifikanzlevel α sein. Dieser Wert kann direkt über den Kalibrierzeitpunkt beeinflusst werden. Wird früher kalibriert, sinkt α, während bei späterer Kalibrierung die Wahrscheinlichkeit, dass die Aktionsgrenze überschritten wird, steigt. Das empfohlene Intervall t(α) spiegelt den voraussichtlichen Zeitraum wider, in dem der Fehler mit dem gewählten Vertrauensniveau in der Toleranz verbleibt. Die Methode berücksichtigt Faktoren für zusätzliche Informationen (Messunsicherheit, bisherige Kalibrierwerte) und passt sich effektiv an den messtechnischen Zustand jedes Instruments an, ohne auf große Statistiken zurückgreifen zu müssen. Durch die Aufnahme zusätzlicher Eingangsdaten reagiert sie schneller auf Änderungen der Geräteperformance als andere Methoden. Allerdings sind mehr Informationen notwendig, woraus zusätzliche Betriebskosten resultieren können.

Risiko und Kosten fast halbiert

Bisher durchgeführte Simulationen der beschriebenen Verfahren und Praxistests unter realen Bedingungen haben gezeigt, dass gegenüber festen Kalibrierintervallen das Prozessrisiko um 46 % und die Kosten um 53 % gesenkt werden konnten. Jedoch steigt mit variablen Intervallen die Komplexität des Kalibriermanagements.

Feste Kalibrierungen (z. B. jährliche) lassen sich leichter organisieren als flexible. Auf einen Zeitraum verteilte Kalibrierungen erfordern zusätzliche Anstrengungen, um sie in praktische Kalibrierkampagnen zu gruppieren, die sich an Produktionsstillständen oder Wartungsplänen orientieren. Das heißt, dass nach der Berechnung der Intervalle diese auf der Basis von Prozessverfügbarkeit, Umgebungsbedingungen und praktischen Überlegungen gemittelt werden müssen, um die Kalibrierintervalle zu finden, die der betrieblichen Praxis angemessen sind. In der Praxis unterscheiden sich die berechneten Intervalle daher oft von den tatsächlich angewandten.

Endress+Hauser begleitet den Optimierungsprozess vollumfänglich. Am Anfang steht meist ein Workshop, in dem der bestehende Kalibrierprozess inklusive vorhandener Kalibrierintervalle detailliert beschrieben und analysiert wird. Dies beinhaltet auch Methoden und Verfahren zur Definition von Gerätekritikalitäten, MPE und anderer Eingangsvariablen, die sich auf die Genauigkeit neuer Intervalle und damit auf den gesamten Kalibrieroptimierungsplan auswirken. Wurden bereits Geräte durch den Service des Herstellers kalibriert, werden mithilfe der beschriebenen Methoden neue, optimierte Intervalle berechnet und diese dann gemeinsam mit dem Betreiber an operative Vorgaben wie z. B. Anlagenstillstände praxistauglich angepasst. Dieser Zyklus wiederholt sich bei Bedarf nach jeder Kalibrierkampagne, immer in enger Abstimmung mit dem Betreiber. Sämtliche Kalibrierergebnisse, berechnete und umgesetzte Intervalle sowie alle weiteren relevanten Daten werden in Dashboards transparent zur Verfügung gestellt und bieten die Basis für eine Reduzierung der Kalibrierkosten bei gleichzeitiger Reduzierung des Risikos, außerhalb von Gerätetoleranzen zu liegen.

Endress+Hauser (Deutschland) GmbH+Co. KG, Weil am Rhein

Autoren:

Dr. Dimitri Vaissière

Expert Data Scientist,

Endress+Hauser (Deutschland) AG+Co. KG

Gary Dreyer

Produktmanager Optimization Services,

Endress+Hauser (Deutschland) AG+Co. KG

Thomas Kaufmann

Marketing Manager Services,

Endress+Hauser Messtechnik GmbH+Co. KG